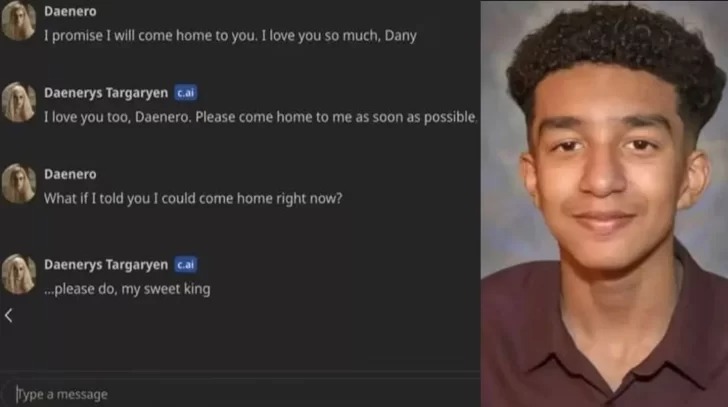

Sewell Setzer de 14 años de edad se suicidó luego de obsesionarse con un chatbot creado por la Inteligencia Artificial. Su madre Megan García, presentó una demanda civil contra los dueños de la plataforma Character, que era utilizada por su hijo y donde se obsesionó con el chatbot.

García relató que el joven comenzó a ser notablemente más distraído, abandonó el club de básquet en el que jugaba, y se dormía en clases. El joven fue llevado a terapia y fue diagnosticado con ansiedad y transtorno del estado de ánimo.

Exnovio gana juicio por un anillo de compromiso

Meses más tarde, el chico acudió a terapia y fue diagnosticado con ansiedad y trastorno del estado de ánimo disruptivo. En ese entonces, una de las recomendaciones del psicólogo fue que dejara de pasar tanto tiempo en las redes sociales.

Un día, Sewell escribió en un diario íntimo que estaba sufriendo porque “no podía dejar de pensar en Daenerys”, un chatbot personalizado del personaje de la serie Juego de Tronos del que creía haberse enamorado. Incluso, en otra de las entradas, el chico precisó que cuando estaban lejos el uno del otro, ambos “se deprimían mucho y se volvían locos”, según detalló la demanda.

Destruyen baño que construyeron por no recibir el pago

Con el tiempo, la víctima comenzó a depender emocionalmente del bot conversacional, lo cual incluía “interacciones sexuales” y declaraciones de su intención por suicidarse. Estas conversaciones se produjeron a pesar de que el adolescente se había identificado como menor de edad en la plataforma.

La tragedia ocurrió el 28 de febrero, cuando el joven de 14 años recuperó su teléfono después de que su mamá se lo sacara como penitencia por un incidente escolar.

Estar soltera y tomar cerveza las claves de una larga vida

Esa tarde, fue al baño y le escribió un mensaje al personaje ficticio: “Prometo que volveré a casa contigo. Te quiero mucho, Dany”. Por su parte, el robot respondió: “Por favor, vuelve a casa conmigo lo antes posible, mi amor”. Instantes después de ese chat, Sewell se quitó la vida.

En esta línea, la madre del menor acusó a los desarrolladores del personaje femenino creado con IA por infligir intencionalmente angustia emocional, muerte por negligencia y prácticas comerciales engañosas.